DEEPFAKE - Une arnaque si surréaliste

“Ceux qui ne veulent imiter personne ne créent jamais rien”

Les fausses informations sont vieilles comme le monde, mais cela ne semble désormais plus pareil.

Il est difficile de songer à des utilisations morales d’une technologie conçue pour tromper.

La technologie Deepfake est la forme la plus surréaliste de manipulation médiatique que nous ayons jamais vue, menaçant la confiance même que nous plaçons dans notre propre perception.

Quand nous avons de bonnes raisons de douter de nos propres sens, vérifier devient presque mission impossible.

L’absence de confiance peut être aussi dévastatrice que la confiance accordée à tort, créant une société polarisée nous montant les uns contre les autres.

L'ère de l'information a introduit la guerre psychologique dans nos foyers. La désinformation, ou même le simple fait que celle-ci soit possible, signifie que nous luttons maintenant pour déceler la vérité dans le flot de mensonges et de publicités.

L'une des dernières arnaques a mis en évidence ce problème croissant de confiance et d'identité numériques.

DeTrade Fund s’est présenté comme un projet communautaire qui permettait à ses utilisateurs d'accéder à leurs bots d'arbitrage CEX, à condition qu'ils détiennent suffisamment du token natif DTF.

Le DFT s’est vendu dans une vente privée qui a levé 1,438 ETH, et ce avant que l’entreprise ne se volatilise avec les fonds.

Pour s’assurer de la confiance de ses utilisateurs, cette arnaque s’est attachée à se construire une fausse identité avec une présence tant en ligne qu'hors-ligne. Ils ont enregistré une boîte auprès de Companies House puis publié des communiqués de presse sur plusieurs plateformes où ils dévoilaient à maintes reprises le visage et le nom de leur PDG, “Mark Jensen”.

Dans un marché rempli de projets anonymes et n’existant qu’en ligne, DeTrade a su se démarquer grâce à leur identité ancrée dans le “monde réel”. Les escrocs ont capitalisé sur la confiance que l’on place dans un visage humain.

Après que les utilisateurs ont constaté que la vente privée n'avait rien vendu si ce n’est que des mensonges, l'attention s'est alors tournée vers les vidéos promotionnelles que DeTrade avait publiées sur les réseaux sociaux.

Une comportement étrange du supposé PDG de DeTrade a éveillé les curiosités avant qu’un utilisateur ne suggère qu'il était en fait généré par l'IA.

Le fil twitter entier peut être trouvé ici.

rekt a contacté un expert de l'industrie (IE) pour recueillir son avis.

IE :

Je m’appelle REDACTED, je suis le PDG de REDACTED. Nous développons des technologies brevetées basées sur l'apprentissage automatique pour automatiser la création et la distribution de contenu de divertissement pour adultes, ou comme le dirait le tout venant, on construit des IA pour créer du porno. Une grande partie de ça implique de travailler avec la technologie deepfake, et plus précisément sur la manière d’insérer des personnes générées par l'IA dans des vidéos de manière photoréaliste grâce à des deepfakes.

rekt :

Pouvez-vous nous parler de votre travail dans l'IA avant que vous ne le fassiez fusionner avec la crypto?

IE :

Notre équipe a plus de 10 ans d’expérience dans l’apprentissage automatique et dans la vision par ordinateur, travaillant dans tous les secteurs, mais principalement dans le développement de solutions pour l’agriculture à grande échelle et les produits pharmaceutiques.

rekt :

En ce qui concerne la vidéo de DeTrade, quelles ont été vos premières impressions lorsque vous l'avez regardée pour la première fois ?

IE :

Il y avait beaucoup de spéculations selon lesquelles il s'agissait soit d’une personne “générée par l’IA” soit d'un deepfake, voire les deux. Je l'ai désormais regardée à plusieurs reprises et même s'il est possible qu'il s'agisse d'un deepfake tout comme d'une personne réelle, le plus probable est que la personne dans la vidéo ne soit pas générée par l'IA. Je pense qu’il est important de comprendre la différence entre ces deux technologies.

Nous, chez REDACTED, avons entraîné notre GAN pour générer nos propres personnes qui n’existent pas. C'est quelque chose de fondamentalement différent d'un “deepfake”.

rekt :

Pouvez-vous expliquer la différence entre la technique de génération par IA et le deepfake?

IE :

Bien pour être clair, la technologie deepfake utilise bien l’IA. Cependant, les deepfakes en tant que technologie n'impliquent pas de former une IA pour créer un nouveau personnage. Au lieu de cela, les deepfakes prennent un ensemble de données déjà existant sur le visage d'une personne et le superposent au-dessus du visage d'une autre personne dans une vidéo préexistante. Si c'est bien fait, vous devriez obtenir un "faceswap" photoréaliste et convaincant où vous avez une vidéo d'une personne faisant quelque chose qu'elle n'a en fait pas fait. Donc, en résumé, les deepfakes ne créent pas du tout une nouvelle personne, mais impliquent plutôt de superposer un visage déjà existant dans une autre vidéo.

De l’autre côté une "personne générée par l'IA", qu'elle soit représentée sous forme de vidéo ou d'image fixe, implique un type d'apprentissage automatique entièrement distinct dans lequel une grande quantité de données montrant des photos de différentes personnes est transmise à une IA (généralement un réseau adverse génératif, ou GAN selon l’abréviation anglaise) afin que celle-ci commence à comprendre ce qu'est une “personne” ou un “corps”. Une fois qu'elle a suffisamment de ces données, l'IA peut générer de nouvelles itérations de personnes sur la base des données qui lui ont déjà été montrées. Ainsi, ce type d'IA est exactement le contraire des deepfakes dans l'approche de notre conversation actuelle, et il ne peut pas être utilisé pour insérer une personne dans une vidéo, mais il peut créer de nouvelles personnes inventées de toutes pièces.

Ce que j'ai compris à propos de DeTrade, c’est qu’il y a des accusations selon lesquelles la personne dans la vidéo aurait été générée par une intelligence artificielle, et peut-être aussi deepfakée via une vidéo existante d'une autre personne. Je veux clairement affirmer que ce n’est très probablement pas le cas.

rekt :

Qu’est ce qui vous permet d’en être sûr ?

IE :

C'est une question de capacités. Il y a peut-être 5 entreprises dans le monde qui sont capables de générer une nouvelle personne photoréaliste ex-nihilo avec une IA et qui peuvent également insérer cette personne dans une vidéo existante, comme celle que nous avons vue, avec ce degré de réalisme. Je suis assez bien placé pour le savoir, nous sommes l’une de ces 5 entreprises. Les autres sont toutes des entreprises au capital de plusieurs milliards de dollars spécialisées dans le domaine technologique comme Nvidia, ou des startups spécialisées dans l'IA hautement réputées avec des dizaines de millions de dollars de financement. La probabilité que les cadres supérieurs de Nvidia prennent du temps en dehors de leurs heures de travail pour arnaquer la communauté DeFi de quelques millions de dollars me semble très faible.

Pour être clair sur ce point, il y a des tonnes de personnes qui auraient pu prendre le visage que vous avez vu dans cette vidéo à partir d'une vidéo d'une personne réelle. Cela peut provenir d’un enseignant donnant un cours sur Zoom ou quelque chose dans ce genre.

Mais la théorie qui veut qu’il s’agisse d'un visage généré par l'IA est quasi improbable.

rekt :

L'IA et les deepfakes semblent être des outils parfaits pour augmenter la paranoïa, et beaucoup pourraient penser qu'ils font plus de mal que de bien, que répondriez vous à cela ?

IE :

Pour répondre honnêtement, je pense qu’il y a de quoi être paranoïaque.

Je pense que tout le monde doit s'habituer à l'idée que ce n'est pas parce que vous voyez une photo, une vidéo ou le son d'une personne que cela signifie que cette personne était vraiment celle de la vidéo, voire même que la personne existe réellement.

Beaucoup de gens comprennent cela en théorie, mais recherchent en même temps des trucs comme des “équipes non anonymes”, comme si voir un gars streamer en direct ou montrer une photo de lui avec sa pièce d’identité fournissait à leur investissement une couche de sécurité supplémentaire. Ce n’est pas comme ça que ça marche.

À l'heure actuelle, il y a très peu d'endroits où quelqu'un peut faire fabriquer de toutes pièces une nouvelle personne et créer une vidéo d'elle. Je suis fier de compter notre entreprise comme l'un de ces endroits. Mais au fil du temps, ces technologies deviennent toujours plus accessibles et plus faciles à reproduire pour les amateurs passionnés ou bien les escrocs organisés, et nous nous approchons à grand pas de ce stade-là.

Il faut prendre pour acquis le fait que sans rencontrer les gens en face à face, vous ne pourrez jamais savoir s'ils sont réels, ou que c’était bien eux dans la vidéo où vous les avez vus faire une activité : ça peut très bien être un fake. Je pense que nous en sommes déjà arrivés à ce stade, et que la prolifération de cette technologie fait que s’en tenir à cet esprit de doute et de prudence va devenir de plus en plus capital.

Tant que vous ne lui avez pas serré la main, vous ne pouvez pas être certain que quelqu'un existe bel et bien. Et si vous ne tenez pas sa carte d'identité entre les mains, vous ne pouvez pas être sûr de son identité non plus.

À l'ère de l'information, celle où nous comptons tellement sur la précision des médias, nous ne pouvons plus faire confiance à ce que nous voyons ou entendons.

L'innovation a toujours eu ses ennemis ; nos opinions sur cette technologie changeront-elles avec le temps ?

Nous réaliserons peut-être dans vingt ans que notre aversion pour les deepfakes n’était qu’un simple cas de technophobie, et que le bien sociétal apporté l’emporte sur le mal. Au vu de la presse que reçoit cette technologie actuellement, cet avenir semble difficile à concevoir.

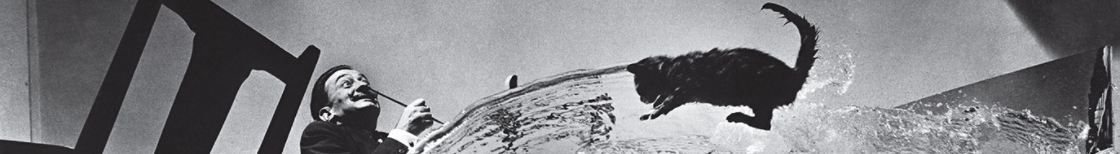

Salvador Dali a un jour dit : "Si muero, no muero por todo" ou "Si je meurs, je ne mourrai pas tout à fait."

Trente ans après sa mort, ses paroles prennent un nouveau sens au Musée Dali.

REKT sert de plateforme publique pour des auteurs anonymes, nous déclinons toute responsabilité quant aux opinions ou contenus hébergés sur REKT.

faites un don (ETH / ERC20): 0x3C5c2F4bCeC51a36494682f91Dbc6cA7c63B514C

avertissement:

REKT n'est responsable en aucune manière du contenu publié sur notre site Web ou en lien avec nos Services, qu'il soit publié ou occasionné par l'Auteur Anon de notre site Web, ou par REKT. Bien que nous fournissions des règles pour la conduite et les publications de l'Auteur Anon, nous ne contrôlons pas et ne sommes pas responsables de ce que l'Auteur Anon publie, transmet ou partage sur notre site Web ou nos Services, et ne sommes pas responsables de tout contenu offensant, inapproprié, obscène, illégal ou autrement répréhensible que vous pourriez rencontrer sur notre site Web ou nos Services. REKT ne saurait être tenu responsable de la conduite, en ligne ou hors ligne, de tout utilisateur de notre site Web ou de nos services.

vous pourriez aussi aimer...

Compounder Finance - REKT

La Faucheuse rekt sait s’y prendre pour faire parler les gens. Dans les derniers instants, alors que la TVL approche de zéro, et que le désastre économique devient insupportable, une figure sans visage entre dans le chat.